BIld av Alexander Antropov från Pixabay

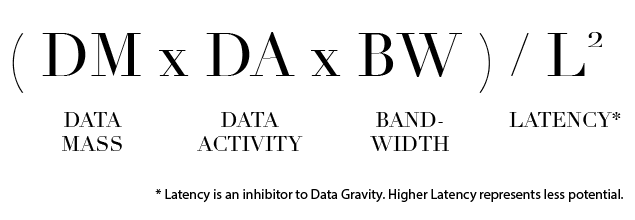

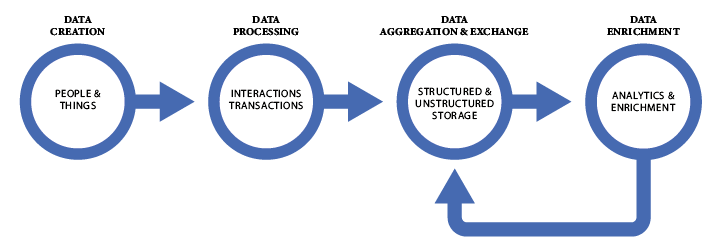

Big data är numera massive data och värre ska det bli. Mycket data som behandlas blir nämligen ännu mera data. Genom att använda sig av en formel från fysiken kan man verkligen se hur en gravitationskraft drar till sig flöden som ska analyseras vilket kvantifierar datamängden.

Vi har nu kommit till en punkt där datahanteringen är så stor att den begränsas av flera faktorer. Data genereras ju på många sätt allt från i on-premlösningar, diverse cloudstrukturer ända ut i IoT och edge. I en rapport från Digital Reality listas Stockholm som en av världens 53 största hubbar, och vi är inte minst.

Ett stort problem med den enorma ökningen är att data kan skapas på för långt avstånd från varandra, att föra över data till applikationer tar tid vilket drar ner på analyshastigheten. En annan är att data finns i många källor. En tredje är de regulatorer, som GDPR, som läggs ovanpå. Det som krävs för att vara i framkant är så lite latency som möjligt. Därför krävs nu en ny typ av centralisering av data för att hålla hastigheten uppe.

Om basdata är stort är det ändå inte allt. Analys och andra verktyg genererar ännu mer data som ska lastas in. Lösningen på problemet är att hålla allt data nära applikationerna. För att lyckas med det krävs en centralisering där data lagras på samma ställe.

Brancher som redan har mycket data kommer att driva på utvecklingen. 2024 förutspås 80% av allt data ligga inom företag. I Sverige är det främst retail, bank och finans samt vad som kallas Proffessional Services (Spotify, spelbolag mm) som ligger i framkant. De kommer att vara avgörande inför framtiden.

Tiden är inne då agnarna skiljs från vetet och den som inte redan är framme måste ligga i för att vara konkurrenskraftig och bygga sin arkitektur på ett sätt som möjliggör ännu snabbare datahantering. Står du inför utmaningar är det dags att lyfta frågan med en expert, som Middlecon, på området. Att sitta stilla och tryggt i båten är ett risktagande inget digitalt bolag kan göra idag.